La gran cantidad de datos que serán generados en nuestras organizaciones 4.0 requerirá del uso de Servicios software especializados para manipularlos de forma muy eficiente. Llamamos Big Data al conjunto de técnicas de manipulación en el que los medios tradicionales de procesamiento son ineficaces ya que:

Por eso se dice que para que un problema de manipulación de un conjunto de datos deba abordarse por técnicas Big Data debe cumplir la denominada regla de las 4 uves; Volumen, Velocidad en la frecuencia de los datos, Variedad y Veracidad. A esta regla se le añade la quinta v, la “v” de Valor.

Sabemos que los datos de nuestras organizaciones pueden proceder de distintas fuentes, de la comunicación entre máquinas (IoT, PLC’s, sensores), de personas con máquinas (web, redes sociales) o de personas a personas (Mensajería, e-mail, llamadas). Lo importante de cara a la manipulación de los mismos es conocer si éstos siguen algún tipo de estructura que nos permita analizarlos y manipularnos de forma más eficiente.

Se denominan datos Estructurados, a aquellos que han sido generados de una manera predefinida y por consiguiente siguen una determinada estructura pudiendo ser almacenados en tablas, como por ejemplo; formularios, transacciones bancarias, recibos, etc.

Los Datos No Estructurados por el contrario, son aquellos que son creados normalmente a partir del comportamiento de un usuario (publicaciones, páginas web visitadas, textos, búsquedas en Google, audios, videos) y no poseen un formato definido que permita almacenarlos de la forma tradicional.

Entre estas dos tipologías de datos, existen además los llamados datos Semiestructurados o Híbridos que siguen cierta estructura pero con variaciones respecto al patrón, por lo que no pueden ser gestionados como datos estructurados. Son por ejemplo los códigos HTML de nuestro Website.

Las técnicas de Big Data, se centran principalmente por su complejidad en la gestión de los datos No Estructurados y Semiestructurados pues se ha convertido en uno de los principales retos a los que hacen frente las compañías en lo relativo a gestión de información y la toma de decisiones. Los textos de las Redes Sociales, la información subyacente en las imágenes, los vídeos y los ficheros de audio contienen información valiosa para las organizaciones y son algunos de los retos más demandados.

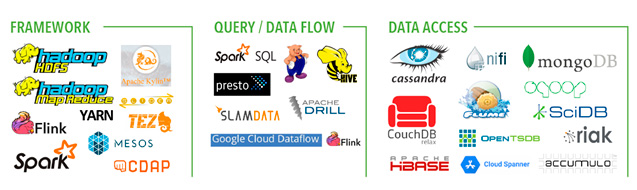

Compañías de redes sociales como FaceBook o LinkEdin y las de buscadores como Google o Yahoo han sido los grandes impulsores del Big Data y actualmente es una de las tecnologías habilitadoras aplicable a la Industria 4.0 que ha sufrido mayor crecimiento. Su ecosistema de infraestructuras, productos y servicios no para de crecer como muestra el Landscape de Matt-Turck para este año. En la figura siguiente mostramos algunas de las tecnologías abiertas (Open Source) más usadas.

Se dice que una organización está dirigida por los datos (data-driven) cuando fundamenta sus decisiones estratégicas en el conocimiento obtenido a partir del análisis de los datos de los que dispone.

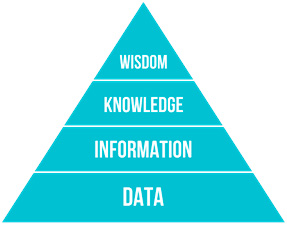

Por tanto, debemos construir un ecosistema del dato óptimo para que podamos generar sabiduría partiendo de los datos en bruto que generan todos los agentes de nuestra cadena de suministro; máquinas, proveedores y sobretodo clientes.

Para ello (ver figura siguiente) necesitamos extraer información de los datos pues los datos brutos no son información en sí mismos. De la información obtenida al procesarlos podremos construir conocimiento en una segunda fase y el conocimiento adquirido podrá catapultarnos hasta alcanzar la sabiduría en la materia y dotarnos de capacidad predictiva.

En definitiva, los datos en crudo no son útiles para nuestra organización y para poder extraer conocimiento de ellos es preciso plantear un proyecto serio de Big Data pues vamos a tener que construir un modelo, basado en los datos recopilados, que sea una descripción de los patrones y relaciones entre los datos con los que se puedan hacer predicciones, entender mejor los datos o explicar situaciones pasadas.

Antes de iniciar un proyecto Big Data tenemos que tener muy claro cuál es el problema a resolver y para ello debemos ser capaces de responder a preguntas como las siguientes:

Las respuestas a estas preguntas serán claves para poder orientarnos sobre las herramientas Big Data más adecuadas según el caso (Clasificación, Regresión, Clustering, etc.) y los algoritmos a usar a lo largo de los procesos que tendrán lugar desde que el dato es creado hasta que es explotado; Ingesta, Almacenamiento, Procesamiento, Análisis y Visualización. A continuación explicamos muy someramente en qué consiste cada uno de ellos:

Dependiendo del tipo de datos que vayamos a tratar tendremos que alimentar las bases de datos de una forma u otra. El dato puede proceder de tablas o archivos finitos ubicados en distintos lugares (procesamiento por lotes o Batch) o proceder de flujos continuos procedentes de la red o Streaming.

Los proyectos de Big Data suelen manejar grandes volúmenes de información no estructurados y tendremos que usar herramientas capaces de manipularlos sin perder la sensación de trabajar en tiempo real. Cassandra, Hadoop HDFS, MongDB o Elastic, son algunos ejemplos de herramientas que nos proporcionan estas prestaciones.

El procesamiento de los datos es el verdadero corazón del Big Data pues requiere herramientas capaces de operar de manera distribuida con objeto de repartir el trabajo entre varios nodos de computación (normalmente en la nube) y efectuar operaciones costosas en poco tiempo. Destaca, sobre todo Spark, que acelera los procesos al trabajar en memoria distribuida compartida.

Analizar los datos requiere hacer muchas y complejas operaciones con grandes bloques. Para realizar estos cálculos de forma eficiente se utilizan lenguajes de programación como R o Phyton. Estos lenguajes además disponen de potentes librerías de Machine Learning por si queremos predecir en base a la experiencia.

Por último, para la visualización de los datos se utilizan bibliotecas de consulta como Hive o Spark SQL que nos entregan los resultados casi de forma instantánea. A posteriori la información obtenida se procesa mediante el algoritmo que hayamos diseñado para ello y se expone, utilizando herramientas como Google Chart, D3.js, Tableau o Plotty, en intuitivos dashboards.

Como podemos observar, dominar las técnicas de Big Data resulta muy complicado, de ahí que los expertos en estos temas, llamados científicos de datos, estén tan demandados actualmente.

El dominio del Big Data permitirá extraer petróleo a nuestra organización ya sea por la venta o por la explotación del dato

El fenómeno Big Data ha alcanzado a organizaciones de todos los sectores. Los bancos, las aseguradoras, las operadoras de telefonía, las compañías de suministro son conscientes de la importancia que tiene el correcto tratamiento de los datos, entre otras cosas porque generan grandes ingresos con la venta de los mismos.

Sin embargo, más que en la venta, el interés está centrándose en el uso del dato para crear Valor en la explotación del negocio. Utilizar Big Data e Inteligencia Artificial conjuntamente permite un nivel de conocimiento de nosotros mismos y de nuestros clientes, fundamentales para tomar decisiones, de manera mucho más informada.

El conocimiento resultante de esta cooperación es exclusivo porque reúne, la experiencia de la organización, el Know How de los empleados y los datos obtenidos de los procesos

Con esta “simbiosis tecnológica” hemos pasado de obtener respuestas diagnósticas o correctivas a preguntas sobre el presente y el pasado, a poder dar respuestas de pronóstico o predictivas basadas en lo que ocurrirá a futuro que nos ayuden a ser más competitivos en un mercado donde reina la incertidumbre. ¿Por qué pasan las cosas? ¿Continuará la tendencia actual en el futuro? ¿Qué pasará a continuación? ¿Qué es lo mejor o peor que puede pasar?.

En otras palabras:

Usaremos Big Data e IA para conocer cómo se manifiestan las tendencias en los comportamientos de nuestros clientes, qué afecta realmente a su conducta de compra y cómo se pueden predecir e influir sobre ellas

¿Eres un proveedor de soluciones TIC y quieres aparecer en este portal?

¿Eres una empresa y no encuentras lo que estás buscando?

Recibe, cada dos semanas, todas las novedades sobre las tecnologías de la información para empresas.